用完这次更新的豆包 我想把PS卸了

有一说一,前几天就已经立冬了,眼瞅着又快到年底了现在。

搁往年的情况,到了年底这才到各大厂商纷纷发力的时候,年关将近嘛,总得搞出点啥新东西,给大家涨涨眼界。

虽然说最近关于 AI 的新消息不是很多,但是人家这段时间肯定也没闲着,这不,一个多月前,也就是 925 那天我们才跟大家说了豆包的视频生成,这两天,豆包又又又上新了新功能。

简单来说,这回豆包支持 “ 一句话编辑修改图片 ” 了。

虽然文生图已经搞了两三年,但这回,我敢说真算是国产 AI 文生图里的新突破了。

可能不少差友还觉得, AI 生图不是已经挺厉害的了嘛,怎么还不能修改图片?

实际上,我们这几年也测了不少文生图大模型了,支持图片精确修改的还真没有,目前做的最好的真就是豆包。

就比如说 ChatGPT-4o ,你让他画个打篮球的人还可以,但是你要想改动一下,把环境换成沙滩,不好意思,整张图都变了。

不止 OpenAI 的不行,谷歌的 Gemini 也一样。

本来说让它把图中的鸡变成鳄鱼,结果不仅没变成,还把背景给全改了,两次的篮球也完全不一样。

拿 AI 自己生的图搞都这样,更别说本地上传的照片了。

就拿最简单的给图像换颜色来说,即使在豆包以前的版本里,这种效果也不理想。

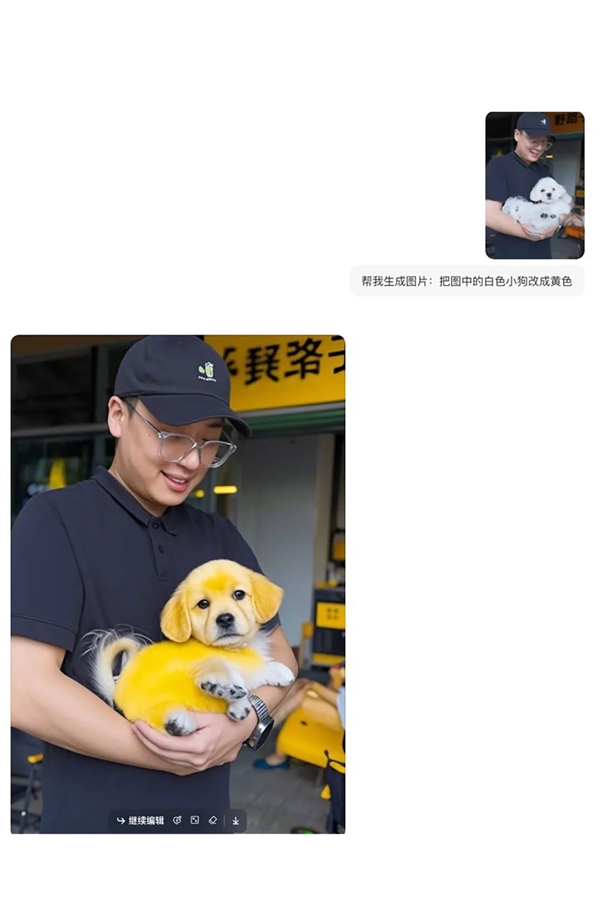

比如我们直接把 925 活动里,给脖子哥拍的照片传上去,然后告诉豆包,你给我把脖子哥抱着的小白狗换成小黄。

结果就是,整张图都变了,风格大变就算了,构图也不一样。

但是现在,这回用上这个上新了的豆包,同样的照片同样的提示词,你再看看:

滑动查看AI效果

虽然有一点点小瑕疵,但要跟前面的一比,是不是高下立判!

不但保留了脖子哥的动作,表情,小狗的形状也跟上传的图差不多,说换成黄色就换黄色,一点不含糊。

再来试试图像消除,效果也不错。

Prompt: 帮我生成图片:消除白色小狗

发现没,这个文生图变得智能了,它能识别出照片里的内容,你想修改啥他就只改啥,哪里不对改哪里, so eazy!

而且不仅能做到识别,修改颜色,消除物品这些基本功能,你想整点复杂的也一样可以。

比如更换图片的背景。

我们把差评硬件部视频里,米罗的照片传上去,然后叫豆包把我们的拍摄间背景改成上海陆家嘴。

Prompt: 帮我生成图片:背景换成陆家嘴

哎嘿!还真就换成了,纸张的折痕还都一点没变。

你甚至可以分得清背景里,哪个是 “ 开瓶器 ” 环球金融中心;哪个是 “ 注射器 ” 金茂大厦;哪个是 “ 打蛋器 ” 上海中心大厦,陆家嘴三件套安排的明明白白。不知道的故意第一眼看去,还真以为我们公司搬到浦东了。

除了这些现实中存在的场景,科幻作品中想象的东西,这回豆包也能够生成。

我们让豆包把米罗改造成战锤 40K 风格,结果也是相当的 amazing 啊,虽然换了个人种,但是五官还算依稀能看出米罗的影子,要是戴上头盔,真就跟星际战士一样了。

Prompt: 帮我生成图片:衣服换成战锤40K装甲,手拿激光炮

更重要的是,虽然人物的着装和风格变了,但图片前面的桌子,跟背景的墙壁、窗帘、挂画可都是一点没动。

就这个效果,你要不跟别人说,谁知道这到底是 AI 生成还是 PS ,一眼望去是真分不清。

不过,在人物测试中我们还发现,如果你拿AI 生成的图进行修改,效果比用照片还要强上不少。

你比如就说,我们先生成一张屏幕前各位彦祖的日系写真,然后告诉豆包,把彦祖的衬衣换换颜色。

Prompt: 帮我生成图片:衣服颜色换成棕色

你瞅瞅,脸部的细节,头发的细节,甚至背后墙砖上的纹理,远处的电线杆子,都一点没动,说换装就换装,那叫一个干净利落。

当然了,用人像演示还是为了测试它在人脸细节上的把握能力,毕竟人脸这玩意,一但生成的不好,就会产生恐怖欢乐谷效应,一眼盯真的事。

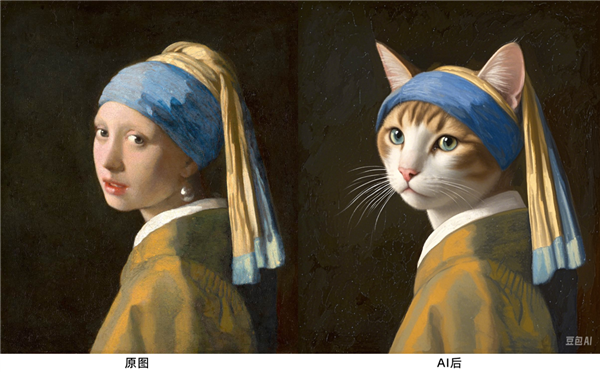

戴珍珠耳环的少女都见过吧,世界名画,我们让豆包给你把人脸换成猫脸版本,来看看它对跨物种的面部融合做的咋样。

Prompt: 帮我生成图片:把人脸换成猫

结果整体瞅下来,表现还是相当不错。不但保留了头饰、衣服纹理的细节,小猫耳朵这块也处理的很好,没穿模,直接能拿去当微信头像用了。

除了照片人像这些,物品啥的理论上会更容易,但是我们还得测,比方说汽车。

我们把一张大众 CC 的照片传上去,让它给换成奔驰。

Prompt: 帮我生成图片:车头换成奔驰

结果也还行,前脸一套都改成了奔驰 C260 ,还是现款的,其他的像车身颜色,周围的环境,也都没变。

但遇上了多人物,复杂场景的情况下,豆包又会表现成啥样呢?

就像刘华强买瓜这段,咱今天就把这个换成刘华强买炸鸡和棉花。

结果效果还怪好嘞,瓜贩子衣服上的图案都一模一样,所有的西瓜都改掉了,特聪明。

Prompt: 帮我生成图片:把西瓜换成棉花和炸鸡

还有一个重点是,如果同时给豆包不同的修改要求,它能不能全部完成。

就比如,西游记里的唐三藏,我想给改成战地版唐三葬,给的提示一句话里有三个指令,同时要完成戴墨镜,拿机枪,换背景,三样任务。

滑动查看AI效果

Emmm ,结果还是全部都完成了,效果也可以。墨镜一戴谁也不爱,身处战场手拿机枪,六根清净贫铀弹,一息三千六百转,杀生为护生,斩业非斩人,主打一个物理超度。

综合来看的话,不止照片、视频截图,包括在制作梗图表情包这一块,豆包都能够手到擒来,即便细节上还能发现可以提高的地方,但话又说回来,不怕人比人,就怕货比货嘛。

就目前来说,比起以前的文生图模型,确实是高的不知道哪里去了。

看到这可能有差友就要问了,世超鸽鸽,为啥豆包这次突然就跟换了个妈妈生的一样,比之前聪明了这么多?

该说不说,这里面确实有门道。

这么说吧,我们以前用的文生图模型,基本用的都是 Diffusion 技术,是先把图片一步步变糊,然后反向分析怎么从糊到清晰,从而产生新的图像。

但问题是,在这个过程中,模型生成图像是基于全局信息的,要想局部修改,不好意思,整体全都要重来,所以每次生成的都不一样,也没法在细节上再调整。

我们这两年也测了不少文生图模型,咋说呢,东西是没问题,可以生成,但都没法一模一样的,准确还原出想象中那个样子,就比如这种:

是不是感觉跟人家用的都不是一个软件?

图源:Mac Baconai , “Al 的异星 cult 幻想之城 ”

可要实现人家这种效果,提示词弄的就得巨复杂,还要微调很久很久,甚至他们还编纂了专门的提示词辞典。大伙要是没训练过这个,实际上就很难做好图,更别说把自己的照片传上去编辑了。

如果能像画画一样,哪里不对改哪里,逐渐成型就好了。

而豆包这次更新的,正是这个方向。为了实现图片编辑的效果,豆包这次的文生图采用的是 SeedEdit 模型。

相比只是通过文字生成,这玩意更微操,它会把图片的理解和生成融合到一个统一的大模型框架里,从而在生成和编辑图像的时候,可以事无巨细的参考咱传上去的图像,完事儿控制的就相对精准,而且出来的图片也更自然。

打个比方,如果说以前的文生图模型是无情泼墨画匠, SeedEdit 就更像画笔精巧,有创造力的画家。实际我们上面用下来,可以说效果确实相当不错。

实际上, SeedEdit 这样的技术,目前行业内也刚开始用,能集成在 AI 助手里的,豆包其实是第一家。

而像 AI 编辑图片这种方向,现在早就已经是是图片编辑行业的标配,各种修图软件、剪辑软件甚至手机相册里都在做。

但是先不说效果,起码现在其实大多数产品都还是要手动涂抹修改,或者自己在上面 P 图,加配饰,不知道大伙怎么觉得,我反正每次 P 背景,消除人物,都得花不少功夫。。。

至于 AI 直接出的图嘛,咱上面也说了,跟抽卡似的,很难一次就有理想的图,还没法再二次修改。

这也就是为啥咱开头就说,由 AI 直接控制的编辑修改图片,会是一个技术突破了。

换句话说,这个技术不仅改变的是 AI 文生图,其他的照片修改、视频剪辑啥的,基本全都能用得到。

到时候,直接跟语音助手说一声给我出图!AI 就帮你往你想的方向调整,美美当甲方,想想都爽。

还没有评论,来说两句吧...